ChatGPT의 새로운 시작: 이미지와 음성으로 대화하기

OpenAI가 또 한 번의 놀라운 업데이트를 발표했다. 뛰어난 언어능력으로 세상을 떠들썩하게 하더니 이제 보고 듣고 말하는 것으로 그 능력을 확장한다고 한다.

ChatGPT는 뛰어난 언어능력에서 시작해 챗봇, 업무 자동화, 검색, 광고, 마케팅, 영화, 게임 등 여러 분야에 적용되며 혁신을 이끌고 있는데 이번 업데이트 역시 단순히 ChatGPT가 음성과 이미지를 인식하는 것을 넘어 사람들이 정보를 찾고 활용하는 방식을 변화시키며 다양한 산업과 상황에서 새로운 변화를 일으킬 것으로 보인다.

이번 글에서는 OpenAI가 지난 9월에 발표한 ChatGPT의 새로운 음성과 이미지 인식 기능에 대해 살펴보고 그 활용 사례와 가능성에 대해 생각해 보도록 하자.

음성 기능 (Voice Conversation)

음성 기능은 ChatGPT가 사용자의 목소리를 실시간으로 인식하고 대화할 수 있는 기능이다. 원래 OpenAI는 Whisper라는 음성인식 모델(Speech to Text) 모델을 공개하고 있었는데 여기에 음성 합성 모델(Text to Speech) 모델을 더해 사용자가 말하면 실시간으로 인식해 대답을 음성으로 내뱉는 기능을 가능하게 한 것이다. 이제 사용자는 ChatGPT를 타이핑이 아닌 말하기로 사용할 수 있으며 Open AI는 우선 다음과 같은 활용 장면들을 제시하고 있다.

예를 들면 운전과 같은 이동 중에 ChatGPT에게 물어보거나 가족을 위한 베드 타임 스토리를 읽어 달라고 하거나 저녁 식사 테이블에서 논쟁을 해결하는 것 등이다. 당장 손으로 치는 것에 익숙한데 스마트폰 앱에서 ChatGPT의 음성 기능을 켜고 오늘 날씨는 어떤지 물어보았다. 그랬더니 실시간 날씨 정보는 제공할 수 없다고 한다.

그럼 대화나 논쟁을 해볼까? "내가 요즘 스피닝을 배우는 데 어떻게 하면 스피닝을 잘 탈 수 있는지" 물어보았다. 그랬더니 몇 가지 팁을 말해 준다. Tap을 눌러 중단시키고 "무릎이 안 좋은데 무릎을 안 다치기 위해 주의할 점은 없어?"라고 물어보았다.

내용의 수준은 이전 ChatGPT가 텍스트로 생성하는 것과 비슷한데 이를 말로 읽어주는 느낌이다. 한국어를 인식하고 대답을 하는 것이 꽤 자연스럽게 대화가 이뤄진다. 유튜브에는 이러한 ChatGPT의 챗 기능을 이용해 농담을 주고받거나 영어회화에 활용하는 영상들이 올라오고 있다.

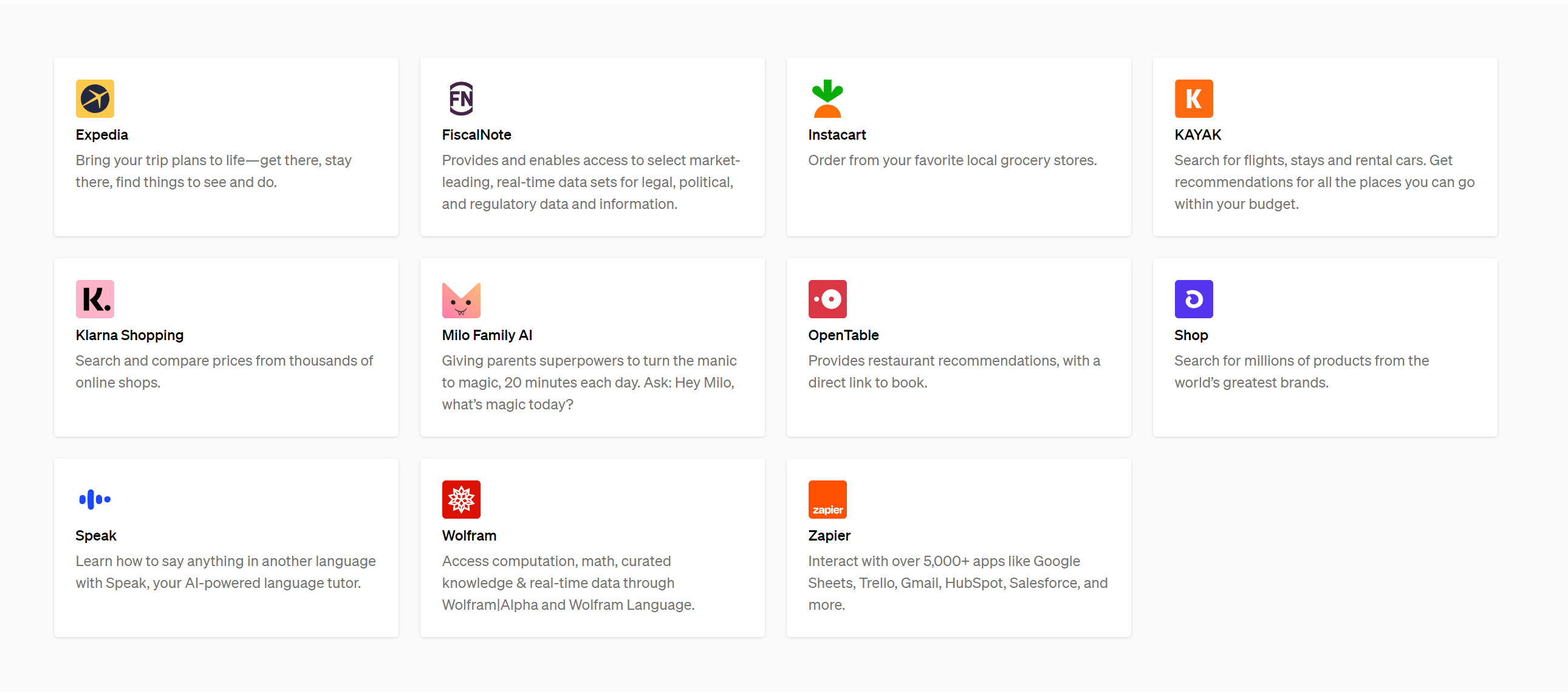

음성 기능은 현재 GPT-3.5와 유료 버전인 GPT-4에서 모두 제공되는데 향후 유료 버전에서 제공되는 실시간 검색 기능인 Browse with Bing이나 서드파티 플러그인들과 함께 사용된다면 파급력이 어마어마할 것으로 보인다.

지금도 GPT-4의 플러그인들을 활용하면 ChatGPT를 통해 Expedia와 같은 여행 사이트에서 여행 예약을 하고 ChatGPT에게 기분에 따라 새로운 플레이 리스트를 작성해 달라고 하고 생성된 리스트를 Spotify에서 바로 들을 수 있을 수 있는데, 이제 말만 하면 ChatGPT가 실시간으로 검색해서 답변해 주고 이메일을 작성해 보내주거나 쇼핑도 할 수 있게 될 수 있는 것이다. 시리나, 알렉사, 빅스비 와 같은 친구들은 이 이름을 부르지 않아도 되는 친구의 등장에 긴장해야 하지 않을까?

ChatGPT가 처음 등장했을 때는 추가 데이터를 학습시켜 ChatGPT가 다 알아서 하는 방향으로 갈지? 아니면 ChatGPT가 전면에 나서고 뒤에서는 특정 서비스의 데이터 베이스나 알고리즘과 연동해 서비스를 제공되는 방식으로 갈까 궁금했는데 지금은 그 방향이 명확해지고 있는 듯하다.

이미지 인식 기능 (Image Recognition)

이미지 인식 기능은 유료 버전인 GPT-4에서 사용이 가능한데 ChatGPT에게 이미지를 첨부하고 물어보면 이미지를 해석해서 대화를 할 수 있는 기능이다. GPT-4를 활용한 기능인데 GPT-4의 자세한 아키텍처는 공개되지 않았지만 텍스트와 이미지 등을 인풋으로 받아 학습하고 텍스트를 생성할 수 있는 멀티 모달(Multi Modal) 모델이라고 한다.

ChatGPT를 사용하는 사람이라면 그런 생각을 한 적이 있지 않을까? 아, 이건 이미지로 첨부해서 ChatGPT한테 물어보고 싶다!

OpenAI에서는 이미지 인식 기능의 활용 사례로 ChatGPT에게 자전거 안장을 낮추는 방법을 물어보는 사례를 제시했다. ChatGPT에게 사진을 찍고 자전거 안장을 낮출 수 있는 방법을 물어보자 ChatGPT가 일반적인 대답을 생성한다. 이 부분을 조정하는 게 맞냐고 사진에 동그라미를 쳐 특정 부분을 물어볼 수도 있다. 사용자가 자신의 매뉴얼과 도구를 찍어 보여주자 툴 박스의 어떤 도구를 사용하라고 정확히 집어서 이야기하는 듯하다.

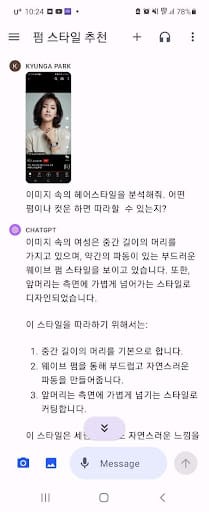

나는 유튜브 쇼츠에서 본 이미지의 스크린샷을 찍어 헤어스타일을 물어보았는데, 레이어드 컷 컷이라든지 허쉬 컷이라든지 원하는 전문적인 대답은 아니지만 마치 꽤나 눈썰미가 있는 사람처럼 대답한다. 전문가는 아니어도 자전거 사용법이든 헤어스타일이든 무엇이든 어느 정도 말해줄 수 있는 똑똑한 Generalist 같은 느낌이다.

이 역시 앞서 음성 기능처럼 특정 데이터 베이스나 알고리즘 등과 연계된다면 다양한 적용 사례를 만들어 낼 수 있지 않을까? 예를 들어 온라인 쇼핑몰이라면 고객이 찍은 사진을 업로드하면 이미지를 인식해 이 옷 혹은 이 옷과 가장 유사한 자사 제품을 찾아주거나 코디법을 제안하는 거다.

또는, 뷰티업체라면 사용자가 찍어 올린 얼굴 이미지를 인식해 ChatGPT가 분석한 텍스트에서 특정과 키워드 등을 추출하고 이런 경우 어떻게 스킨케어나 메이크업 등을 할 수 있을지 노하우나 제품을 알려줄 수도 있을 것이다.

ChatGPT는 처음 나왔을 때 보다 쓰면 쓸수록 감탄하게 되는 서비스 중에 하나라고 생각하는 데 사람들이 기본이라고 생각하는 것들, 예를 들어 PC와 모바일에서 대화한 히스토리가 디바이스에 상관없이 정확히 동기화가 되고 구글을 이용한 로그인 등 사람들이 당연하다고 생각하는 것들은 당연히 잘 구현되어 있다. 한편으로 사람들이 '이렇게 되면 좋을 텐데'라고 생각하는 기능도 이렇게 빠르게 구현되는 것이 놀라울 따름이다. ChatGPT가 이제 텍스트를 넘어 보고 듣고 말하는 능력까지 확장됨으로써 어떻게 사용자의 경험을 다양하고 풍부하게 만들어 갈지 기대된다.

| ||

마테크와 마케팅 데이터 분석에 대해 이야기 합니다. |

* 슈퍼브 블로그의 외부 기고 콘텐츠는 외부 전문가가 작성한 글로 운영 가이드라인에 따라 작성됩니다. 슈퍼브 블로그에서는 독자분들이 AI에 대한 소식을 더 쉽고 간편하게 이해하실 수 있도록 유용한 팁과 정보를 제공하고 있습니다.