슈퍼브에이아이 '독파모' 1차 성과: 한국형 로봇 데이터 108만 프레임 확보

피지컬 AI 시대를 여는 핵심, '로봇 데이터'는 어떻게 만들어질까요? 슈퍼브에이아이가 독자 AI 파운데이션 모델 사업을 통해 구축한 108만 프레임의 한국형 주거 환경 데이터와 VLA 학습 전략, 그리고 로봇이 현실 세계를 이해하는 기술적 노하우를 공개합니다.

2025년을 기점으로 AI의 흐름은 화면 속의 지능을 넘어 현실 세계와 상호작용하는 '피지컬 AI'의 시대로 급격히 이동하고 있습니다. 이제 기술의 핵심은 디지털 세계의 언어를 이해하는 것에서 물리적 세계를 이해하고 행동하는 것으로 바뀌고 있습니다.

하지만 로봇이 "설거지를 좀 해줘"라는 말을 알아듣고 실행하려면 무엇이 필요할까요? 단순히 사람의 말을 텍스트로 이해하는 것만으로는 부족합니다. 복잡한 부엌에서 싱크대의 위치를 찾고, 깨지기 쉬운 유리잔과 무거운 냄비를 구별하며, 수도꼭지를 얼마나 돌려야 물이 적당히 나오는지를 시각적으로 판단하고 물리적으로 조작할 수 있어야 합니다.

공간(3D), 깊이(Depth) 등 텍스트 데이터와는 다른 고품질 시각 정보(Vision Data)는 전 세계적으로 턱없이 부족합니다. 한국의 아파트 주거 환경이나 좌식 문화를 이해하는 데이터도 아직 공개된 바가 없습니다.

이러한 데이터 병목 현상을 해결하고 대한민국 독자 AI 모델의 성능을 글로벌 수준으로 끌어올리는 일을 슈퍼브에이아이가 하고 있습니다. 초거대 AI 모델이 텍스트를 넘어 시각 정보를 완벽하게 이해하고(Vision), 나아가 로봇에 탑재되어 실제 행동까지 수행할 수 있도록 고품질의 VLA(비전-언어-행동 모델, Vision-Language-Action Model)용 학습 데이터를 공급하는 것입니다.

이번 글에서는 ‘독자 AI 파운데이션 모델 개발(이하 독파모)’ 프로젝트의 1차수에서 슈퍼브에이아이가 수행한 핵심 결과를 “무엇을/왜/어떻게” 중심으로 정리합니다.

TL;DR — 슈퍼브에이아이의 1차수 핵심 성과

- 한국 가정 환경 50개소에서 RGB-D 108만 프레임(원시 데이터) 확보

- 학습/검증이 가능한 형태로 30만 프레임(가공 데이터) 자산화

- 17대 멀티뷰 카메라 리그로 로봇 학습에 필요한 장면 정보를 한 데이터셋에 결합

1. 한국형 가정 환경, 의미 있는 108만 개의 프레임을 담다

혹시 유튜브에서 로봇 영상을 보신 적 있나요? 넓은 아일랜드 식탁과 널찍한 주방에서 요리하는 로봇은 멋져 보이지만, 한국의 좁은 'ㄱ'자 주방이나 가전제품이 꽉 찬 다용도실에서도 잘 움직일 수 있을까요?

슈퍼브에이아이는 독파모 1차 사업 기간 동안 한국 가정 50곳을 섭외하여 우리 주거 환경에 딱 맞는 데이터를 구축했습니다.

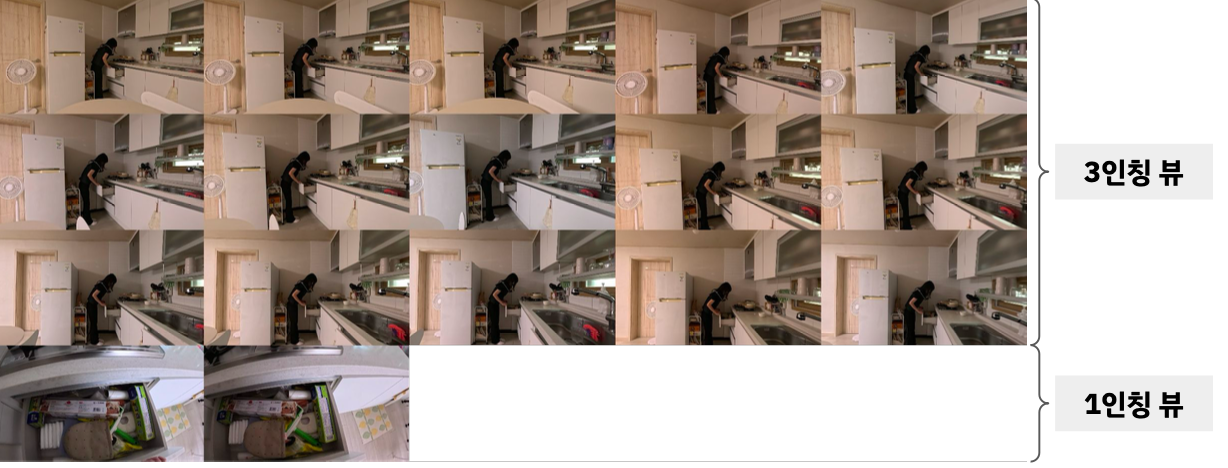

- 🎥 17대의 카메라가 동시에: 단순히 영상을 찍는 게 아닙니다. 로봇의 입체적인 시야를 완벽히 구현하기 위해 고프로(GoPro) 17대를 타임코드 동기화(Timecode Sync) 기술로 묶어 촬영했습니다. 15대는 공간 전체를 보는 '제3자 시점'을, 2대는 로봇의 눈이 될 '1인칭 시점'과 '3D 스캔'을 담당하여 2D 영상을 3D 공간 정보로 재구성했습니다.

- 🏠 150종의 가사 노동 시나리오: 요리, 설거지, 빨래 개기, 물건 정리 등 로봇이 가정에서 해야 할 150가지 행동을 정의하고, 약 7,500회의 상황을 연출하여 방대한 데이터를 확보했습니다.

2. 단순히 '보는 것'을 넘어 '이해하는 것'으로

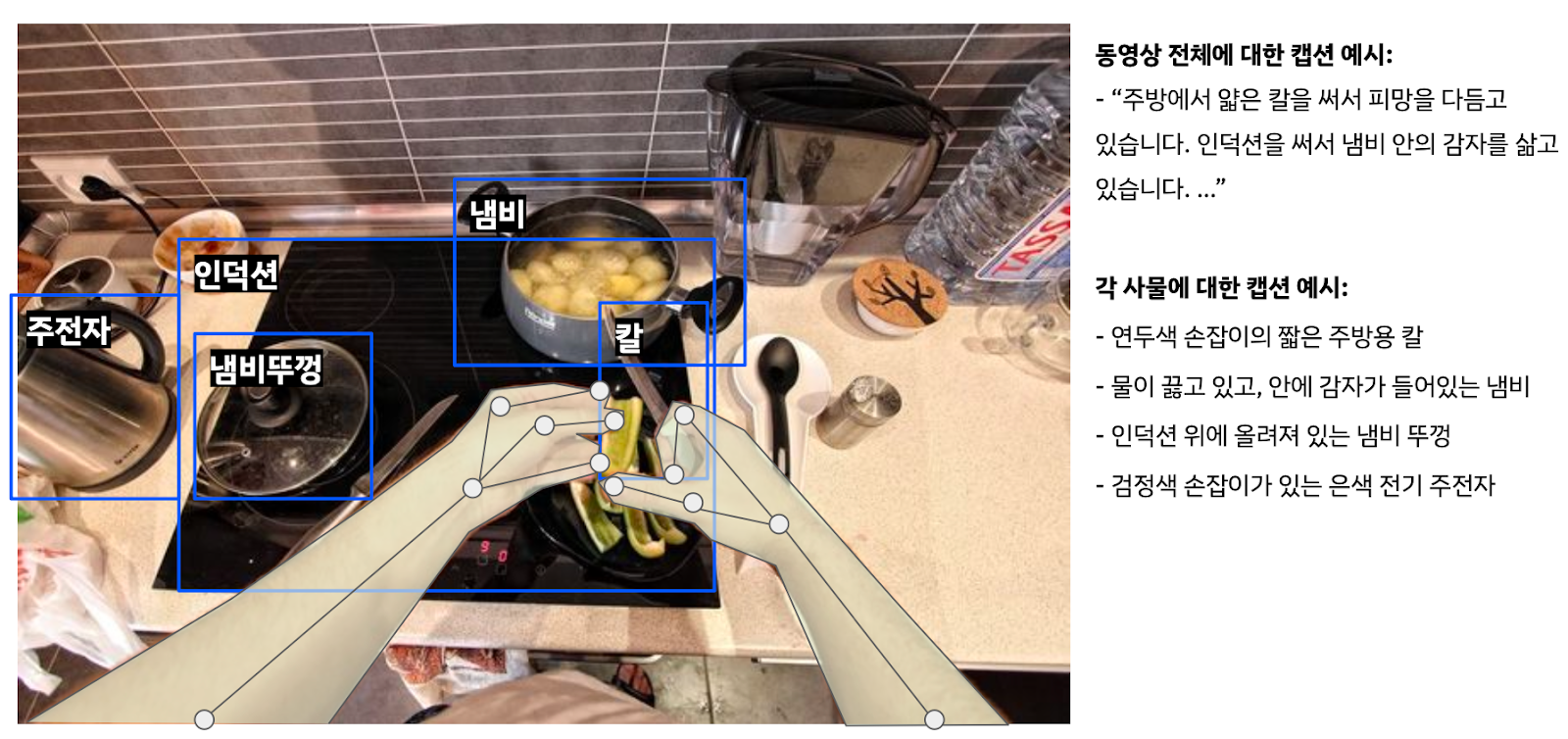

슈퍼브에이아이의 기술력은 단순히 데이터를 많이 모으는 데 그치지 않습니다. AI가 이 데이터를 통해 세상을 '추론(Reasoning)'할 수 있도록 똑똑하게 가공하는 것이 핵심입니다.

1) 시각적 추론

슈퍼브에이아이는 영상에 "사람이 컵을 잡았다"라는 단순한 설명 대신, "물을 마시기 위해(의도) 오른손으로 투명한 유리컵의 손잡이를 잡았다(구체적 행동)"와 같이 행동의 맥락과 인과관계를 포함한 상세한 캡션을 달았습니다. 이를 통해 AI는 단순한 동작뿐만 아니라, 그 행동이 왜 일어나는지를 학습하여 사람의 의도를 파악하게 됩니다.

2) 두 가지 핵심 시점의 집중 구축

슈퍼브에이아이는 로봇이 집 안에서 자연스럽게 움직이기 위해 필요한 시점을 ‘공간을 이해하는 눈’과 ‘조작을 위한 눈’으로 나눠 설계했습니다. 그리고 독파모 1차수에서는 이 중 두 가지 핵심 시점의 데이터를 집중적으로 구축했습니다.

전체를 보는 눈 (3-Viewpoint Integration)

여러 대의 카메라로 공간 전체를 동시에 담아, 방의 구조와 동선, 물체 간 관계처럼 장면의 맥락을 학습할 수 있도록 합니다. 로봇이 “어디에 무엇이 있는지”를 파악하는 기반이 됩니다.

내 손을 보는 눈 (Ego-centric)

로봇이 물체를 집고 옮기는 순간에는 전체 장면보다 “지금 잡으려는 물건”이 더 중요합니다. 1인칭 시점(스테레오)을 통해 손과 물체의 거리, 각도, 깊이 같은 미세 조작에 필요한 정보를 학습할 수 있도록 합니다.

이 두 시점이 결합되면, 로봇은 전체 맥락을 이해하면서도 조작 순간에는 필요한 디테일을 놓치지 않는 방식으로 행동을 계획할 수 있습니다.

3. 슈퍼브에이아이만의 피지컬 AI 기술 경쟁력

이번 1차 사업을 통해 증명된 슈퍼브에이아이의 피지컬 AI 경쟁력은 네 가지로 요약됩니다.

1) 하이브리드 데이터 설계

스튜디오에서 정밀하게 찍은 고품질 데이터와, 실제 가정의 복잡하고 어지러운 환경을 담은 크라우드소싱 데이터를 전략적으로 배합합니다. 이는 로봇이 실험실뿐만 아니라, 아이들이 뛰어놀고 잡동사니가 쌓인 실제 집에서도 당황하지 않고 작동하게 만드는 비결입니다.

2) 4억 프레임 속에서 찾아낸 30만 장의 핵심 자산

단순 계산으로 로봇 학습에 필요한 데이터양을 산출해 보면 규모가 압도적입니다. 50곳의 가정 환경에서 150개 동작을 수행하고, 이를 15대의 카메라가 촬영했습니다. 이는 약 4억 프레임인데요.

하지만 이 모든 데이터를 사람이 직접 검수하고 라벨링 하는 것은 불가능에 가깝고, 비효율적입니다. 여기서 슈퍼브에이아이의 오토 큐레이트(Auto-Curate) 기술이 핵심적인 역할을 수행했습니다.

- 1단계 (4억 → 100만): 의미 없이 반복되거나 정적인 구간을 걷어내고, 데이터로서 가치가 있는 108만 장의 원천 데이터(Raw Data)를 1차로 확보했습니다.

- 2단계 (100만 → 30만): 확보된 원천 데이터 중에서도 로봇이 학습했을 때 성능 향상에 가장 기여할 수 있는, 즉 AI가 헷갈려 할 만한 '엣지 케이스(Edge Case)'와 핵심 동작 구간만을 다시 한번 선별했습니다.

결과적으로 4억 프레임의 데이터에서, AI 모델을 똑똑하게 만드는 데 꼭 필요한 30만 장의 고순도 학습 데이터만을 남겨 자산화했습니다.

이는 단순히 작업 속도를 높이는 것을 넘어, 데이터 구축 비용을 획기적으로 절감하고 모델의 학습 효율을 극대화하는 슈퍼브에이아이만의 데이터 파이프라인 경쟁력입니다.

3) 품질 관리

데이터의 품질은 곧 AI의 지능입니다. 슈퍼브에이아이는 철저한 품질 관리를 통해 단순한 데이터가 아닌, 로봇 공학적으로 유효한 고품질 데이터를 만들어내고 있습니다.

- 1단계 (라벨러): 가이드라인 준수 여부 확인.

- 2단계 (전문 검수자): 다년간의 경험을 가진 전문가가 라벨링의 정밀도 교차 검증.

4) 보안과 신뢰

슈퍼브에이아이는 ISO 27001, SOC 2 Type II 등 글로벌 최고 수준의 보안 인증을 획득했습니다. 모든 데이터는 수집 단계부터 철저한 동의를 거치며, 사람의 얼굴이나 민감한 정보는 자동으로 모자이크 처리되는 비식별화 기술을 적용해 안전하게 관리됩니다.

슈퍼브에이아이의 독파모 사업 1차수 핵심 성과는 한국형 주거 환경에 특화된 고품질 시각 데이터를 확보하고, 이를 실제 AI 모델 학습이 가능한 자산으로 전환했다는 점에 있습니다. 슈퍼브에이아이가 구축한 108만 프레임의 원시 데이터와 30만 프레임의 가공 데이터는, 국내 로봇 AI가 복잡한 실내 공간을 정밀하게 인식하는 기반 인프라로서 기능할 것입니다.

이제 프로젝트는 단순한 '장면 이해'를 넘어, 물리적 세계와 직접 상호작용하는 단계로 진입합니다. 향후 기술 고도화의 방향성은 크게 두 가지 축으로 전개될 예정입니다.

- 정교한 조작 능력: 객체의 단순 인식을 넘어, 손잡이의 각도나 무게 중심 등 물리적 속성을 파악하여 대상을 정확하게 잡고 제어하는 능력 확보

- 행동 기반 AI: "목이 마르다"와 같은 추상적 명령을 "컵을 찾아 물을 따른다"와 같은 구체적인 작업 계획으로 변환하고 실행하는 멀티모달 역량 강화

슈퍼브에이아이는 이러한 로드맵에 맞춰 1인칭 시점 데이터와 언어-행동 결합 데이터셋을 대폭 확장할 계획입니다. 이를 통해 다양한 환경 변수에서도 오차 없이 작동하는 강건한 '피지컬 AI' 모델을 완성하고, 대한민국 AI 기술의 실질적인 경쟁력을 증명해 나가겠습니다.

슈퍼브에이아이의 피지컬 AI 기술력을 현장에 도입하고 싶다면, 아래 내용을 남겨주세요. 슈퍼브 전문가들이 바로 연락 드리겠습니다.