픽셀 너머의 지능: Vision AI 핵심 기술 10선

자율주행, 스마트 시티, 의료 AI 진단 모두 컴퓨터 비전 AI 덕분에 혁신의 폭이 커진 분야입니다. 비전 AI의 핵심 기술 10가지인 이미지 분류, 객체 탐지, 이미지 분할, 얼굴 인식, 이미지 생성 및 변환, 비디오 분석, OCR, 3D비전, 행동 인식, 멀티모달 비전에 대해 살펴보겠습니다.

인공지능의 눈, Vision AI가 세상을 바라보는 방식이 우리의 일상을 혁명적으로 변화시키고 있습니다. 자율주행차가 도로를 누비고, 의료 진단의 정확도가 비약적으로 향상되며, 스마트 시티가 현실로 다가오는 지금, Vision AI는 이 모든 혁신의 중심에 서 있습니다.

이번 글에서는 이미지 분류부터 3D 비전, 멀티모달 비전에 이르기까지 10가지 핵심 기술을 심도 있게 살펴보려고 합니다. 이 기술들이 어떻게 작동하고, 우리의 삶에 어떤 영향을 미치는지, 그리고 앞으로 어떤 가능성을 열어갈지 함께 탐험해 보겠습니다.

1. 이미지 분류 (Image Classification)

이미지 분류는 Vision AI의 핵심 기술로, 입력된 이미지를 사전에 정의된 범주나 클래스로 분류하는 작업입니다. 이 기술은 주로 합성곱 신경망(CNN, Convolutional Neural Network)을 기반으로 하며, CNN은 이미지의 특징을 자동으로 학습하고 추출하여 효과적인 분류를 수행합니다. 예를 들어, 고양이와 개를 구분하거나 의료 영상에서 질병의 유무를 판단할 수 있습니다. 최근에는 ResNet, EfficientNet과 같은 고도화된 모델 구조를 통해 정확도가 크게 향상되었습니다. 이미지 분류는 의료 진단, 자율주행 차량의 환경 인식, 스마트폰의 사진 정리, 전자상거래의 제품 카테고리 분류 등 다양한 분야에서 활용되고 있습니다. 특히, 전이학습(Transfer Learning) 기법을 통해 적은 양의 데이터로도 높은 성능을 달성할 수 있어 실용성이 매우 높습니다. 전이학습은 대규모 데이터셋에서 사전 학습된 모델을 활용하여 새로운 작업에 적용하는 방법으로, 학습 시간과 필요한 데이터량을 크게 줄일 수 있습니다.

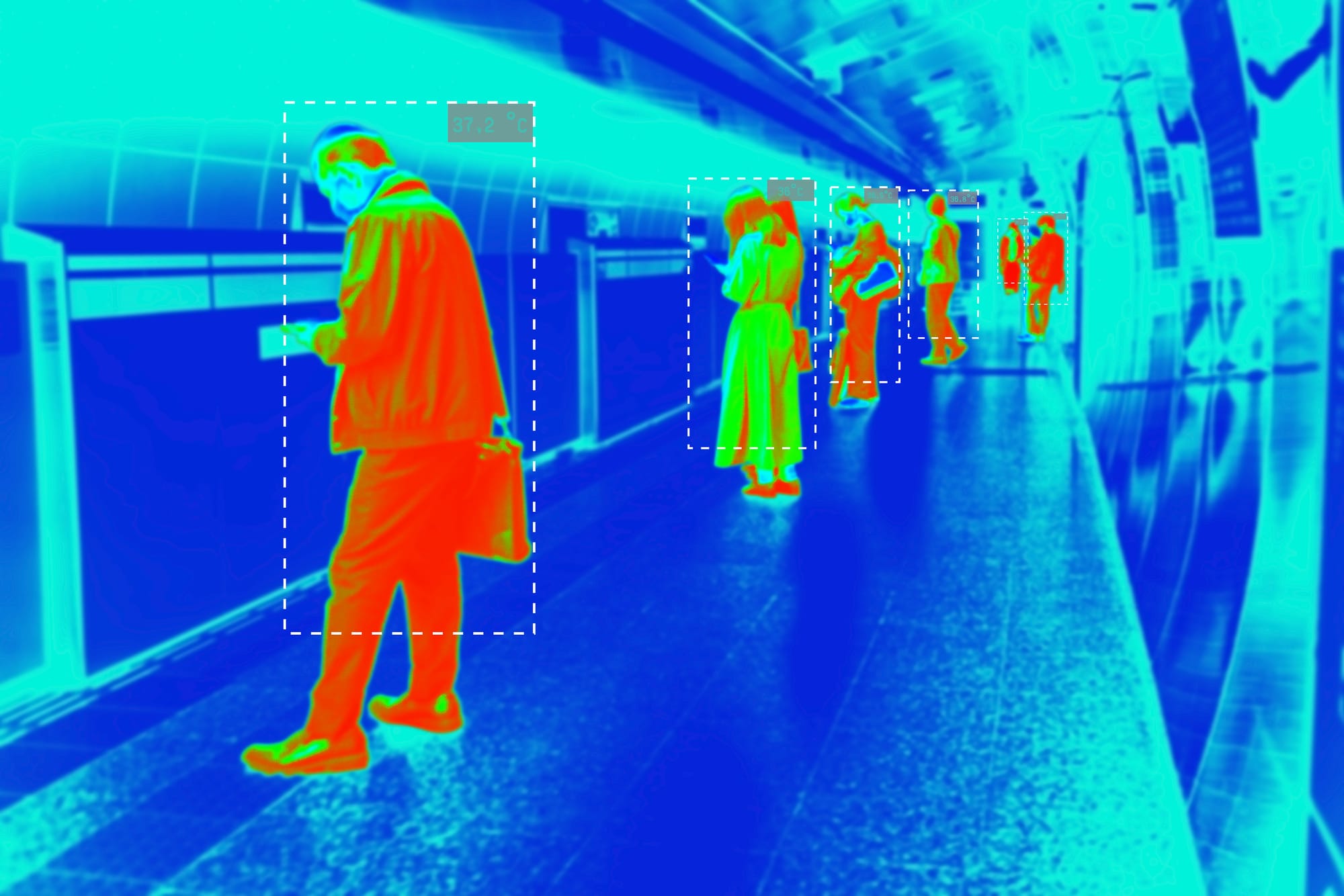

2. 객체 탐지 (Object Detection)

객체 탐지는 이미지나 비디오 내에서 여러 객체를 식별하고 그 위치를 정확히 표시하는 고급 Vision AI 기술입니다. 이 기술은 이미지 분류보다 한 단계 더 나아가, 단순히 객체의 존재 여부를 판단하는 것이 아니라 객체의 정확한 위치와 크기까지 파악합니다. 객체 탐지에는 주로 YOLO(You Only Look Once), Faster R-CNN(Region-based Convolutional Neural Networks), SSD(Single Shot Detector) 등의 알고리즘이 사용됩니다. YOLO는 '한 번만 보면 된다'는 의미로, 이미지를 한 번만 처리하여 빠른 속도를 자랑합니다. Faster R-CNN은 정확도에 중점을 둔 2단계 탐지 알고리즘이며, SSD는 속도와 정확도의 균형을 추구하는 1단계 탐지 방식입니다. 이 기술은 자율주행차에서 도로 위의 차량, 보행자, 신호등을 감지하거나, 보안 시스템에서 침입자를 탐지하는 등 다양한 분야에서 활용됩니다. 또한 제조업에서는 생산라인의 불량품을 자동으로 검출하고, 의료 분야에서는 X-ray나 MRI 영상에서 종양을 찾아내는 데 사용되어 정확성과 효율성을 크게 향상시키고 있습니다. 최근에는 실시간 객체 탐지와 3D 객체 탐지 기술도 발전하고 있어, AR/VR 및 로봇 공학 분야에서도 그 응용 범위가 확대되고 있습니다.

3. 이미지 분할 (Image Segmentation)

이미지 분할은 이미지를 픽셀 단위로 분류하여 객체의 정확한 경계와 형태를 식별하는 고급 기술입니다. 이는 객체 탐지보다 더 세밀한 수준의 분석을 제공합니다. 예를 들어, 의료 영상에서 종양의 정확한 크기와 모양을 파악하거나, 자율주행 차량이 도로, 보행자, 다른 차량의 정확한 윤곽을 인식하는 데 사용됩니다. 대표적인 알고리즘으로는 Mask R-CNN과 U-Net이 있습니다. Mask R-CNN은 객체 탐지와 분할을 동시에 수행하는 '인스턴스 분할' 기술이며, U-Net은 의료 영상 분석에 특화된 '의미론적 분할' 기술입니다. 여기서 '인스턴스 분할'은 같은 종류의 객체도 개별적으로 구분하는 방식이고, '의미론적 분할'은 같은 종류의 객체를 하나로 묶어 분류하는 방식입니다. 최근에는 자연어 처리에서 큰 성공을 거둔 트랜스포머(Transformer) 구조를 컴퓨터 비전에 적용한 DETR(DEtection TRansformer)과 같은 혁신적인 모델도 등장하여 성능을 더욱 향상시키고 있습니다. 이미지 분할 기술은 정밀 농업, 위성 영상 분석, 증강 현실(AR) 등 다양한 분야에서 활용되며, 특히 실시간 처리가 필요한 응용 분야에서 그 중요성이 더욱 부각되고 있습니다.

4. 얼굴 인식 (Face Recognition)

얼굴 인식은 이미지나 비디오에서 사람의 얼굴을 탐지하고 식별하는 Vision AI의 핵심 기술입니다. 이 기술은 크게 두 단계로 나눌 수 있습니다: 얼굴 검출(Face Detection)과 얼굴 인식(Face Recognition)입니다. 얼굴 검출은 이미지 내에서 얼굴의 위치를 찾아내는 과정이며, 얼굴 인식은 검출된 얼굴을 특정 개인과 매칭하는 과정입니다. 딥러닝 기반의 CNN이 이 과정에서 중요한 역할을 합니다. FaceNet과 DeepFace 같은 알고리즘은 얼굴의 특징을 고차원의 벡터로 변환하여 효율적으로 비교합니다. 이를 '얼굴 임베딩(Face Embedding)'이라고 하며, 이는 얼굴의 특징을 수치화하여 표현하는 방식입니다. 얼굴 인식 기술은 스마트폰 잠금 해제, 공항 보안 시스템, 소셜 미디어의 얼굴 태그 기능 등 다양한 분야에서 활용되고 있습니다. 최근에는 마스크를 착용한 상태에서도 높은 정확도로 얼굴을 인식할 수 있는 기술이 개발되어 주목받고 있으며, 3D 얼굴 인식 기술을 통해 보안성을 더욱 강화하고 있습니다. 그러나 프라이버시 침해 우려와 인종, 성별에 따른 인식률 차이 등 편향성 문제와 같은 윤리적 이슈도 제기되고 있어, 기술 발전과 함께 사회적 합의와 법적 규제 마련도 중요한 과제로 떠오르고 있습니다.

5. 이미지 생성 및 변환 (Image Generation and Transformation)

이미지 생성 및 변환 기술은 인공지능을 활용하여 새로운 이미지를 만들거나 기존 이미지를 다른 형태로 변형하는 혁신적인 분야입니다. 이 기술의 핵심에는 GAN(Generative Adversarial Networks, 생성적 적대 신경망)이 있습니다. GAN은 생성자와 판별자라는 두 신경망이 서로 경쟁하며 학습하는 구조로, 매우 사실적인 이미지를 생성할 수 있습니다. 대표적인 응용 사례로는 DeepFake 기술이 있는데, 이는 한 사람의 얼굴을 다른 사람의 얼굴로 교체하는 기술입니다. 또한, 스타일 변환(Style Transfer) 기술을 통해 한 이미지의 내용을 유지하면서 다른 이미지의 스타일을 적용할 수 있습니다. 초해상도(Super-Resolution) 기술은 저해상도 이미지를 고해상도로 변환하여 화질을 개선합니다. 이러한 기술들은 엔터테인먼트 산업, 예술 창작, 광고 제작 등 다양한 분야에서 창의적인 가능성을 열어주고 있습니다. 그러나 DeepFake와 같은 기술은 윤리적 문제를 야기할 수 있어, 책임 있는 사용과 규제에 대한 논의도 활발히 이루어지고 있습니다.

6. 비디오 분석 (Video Analysis)

비디오 분석은 시간에 따라 변화하는 영상 데이터를 처리하고 이해하는 Vision AI의 핵심 기술입니다. 이 기술은 연속된 프레임에서 객체의 움직임, 행동 패턴, 이벤트 등을 인식하고 해석합니다. 주로 CNN(합성곱 신경망, 이미지의 특징을 추출하는 네트워크)과 RNN(순환 신경망, 시계열 데이터를 처리하는 네트워크)의 조합을 사용하며, 특히 LSTM(Long Short-Term Memory, 장단기 메모리)이라는 RNN의 변형 구조가 시간적 정보를 효과적으로 처리합니다. 예를 들어, 보안 카메라 영상에서 이상 행동을 자동으로 감지하거나, 스포츠 중계에서 선수들의 움직임을 분석하는 데 활용됩니다. 최근에는 3D CNN(3차원 공간과 시간을 동시에 고려하는 CNN)이나 Two-Stream Networks(공간 정보와 움직임 정보를 별도로 처리하는 네트워크)와 같은 고급 아키텍처를 통해 더욱 정교한 분석이 가능해졌습니다. 이 기술은 스마트 시티의 교통 흐름 모니터링, 의료 분야에서의 환자 행동 분석, 소매업에서의 고객 동선 파악 등 다양한 산업 분야에 적용되고 있습니다. 특히 실시간 처리 능력이 향상되면서 즉각적인 대응이 필요한 상황에서도 효과적으로 사용되고 있습니다.

7. OCR (Optical Character Recognition)

OCR은 광학 문자 인식(Optical Character Recognition)의 약자로, 이미지나 스캔된 문서에서 텍스트를 디지털 형식으로 변환하는 Vision AI 기술입니다. 이 기술은 CNN과 RNN을 결합한 CRNN 구조를 주로 사용합니다. OCR은 문서를 디지털화하여 검색 가능하고 편집 가능한 텍스트로 만들어주며, 이는 업무 효율성을 크게 향상시킵니다. 예를 들어, 명함의 연락처 정보를 자동으로 추출하거나, 스캔된 계약서에서 중요 조항을 빠르게 찾을 수 있습니다. 최근에는 트랜스포머(Transformer) 기반의 OCR 모델이 등장하면서 문맥을 고려한 더 정확한 인식이 가능해졌고, 다양한 폰트, 손글씨, 그리고 복잡한 배경을 가진 이미지에서도 높은 정확도로 텍스트를 인식할 수 있게 되었습니다. 이러한 발전으로 OCR은 금융 기관의 문서 처리, 우편물 자동 분류, 역사적 문서의 디지털화, 자동차 번호판 인식, 그리고 실시간 번역 앱 등 다양한 분야에서 활용되고 있습니다.

8. 3D 비전 (3D Vision)

3D 비전은 2차원 이미지나 비디오를 기반으로 3차원 공간의 구조를 이해하고 복원하는 첨단 기술입니다. 이 기술의 핵심은 깊이 정보(Depth Information)를 추정하여 실제 세계의 3차원적 특성을 디지털로 재현하는 것입니다. 스테레오 비전(Stereo Vision)은 인간의 양안 시차 원리를 모방한 기술로, 두 개의 카메라로 촬영한 이미지의 시차를 이용해 깊이를 계산합니다. LiDAR(Light Detection and Ranging) 기술은 레이저 펄스를 발사하고 반사된 신호를 측정하여 직접적으로 거리를 측정함으로써 매우 정밀한 3D 맵핑을 가능케 합니다. 이러한 3D 비전 기술은 자율주행차의 환경 인식, 증강현실(AR)과 가상현실(VR) 콘텐츠 제작, 로봇의 물체 조작 등 다양한 분야에서 활용되고 있습니다. 특히 제조업에서는 제품 품질 검사와 로봇 제어에, 건설업에서는 건물의 3D 모델링과 현장 관리에 적용되어 생산성과 안전성을 크게 향상시키고 있습니다. 최근에는 딥러닝 기반의 3D 객체 검출과 분할 기술이 발전하면서, 더욱 정확하고 효율적인 3D 장면 이해가 가능해지고 있습니다.

9. 행동 인식 (Action Recognition)

행동 인식은 비디오 속에서 사람의 동작이나 특정 이벤트를 자동으로 감지하고 분류하는 Vision AI 기술입니다. 이 기술은 주로 3D CNN과 Two-Stream Networks(이중 스트림 네트워크)와 같은 고급 알고리즘을 사용합니다. 3D CNN은 시간 차원을 포함한 3차원 데이터를 처리하여 동작의 시간적 특성을 포착합니다. 이는 일반적인 2D CNN이 정지 이미지를 처리하는 것과 달리, 연속된 프레임 간의 관계를 학습할 수 있게 해줍니다. Two-Stream Networks는 공간적 정보(단일 프레임의 외형)와 시간적 정보(연속된 프레임 간의 움직임)를 별도로 처리한 후 통합하여 더 정확한 행동 인식을 가능하게 합니다. Transformer 구조를 활용한 ViViT(Video Vision Transformer)와 같은 모델과 이 기술이 결합되어 헬스케어(노인 낙상 감지, 환자 재활 모니터링), 스포츠 분석(선수 동작 분석), 보안(이상 행동 감지), 스마트 홈(일상 활동 모니터링) 등 다양한 분야에서 활용되고 있습니다.

10. 멀티모달 비전 (Multi-Modal Vision)

멀티모달 비전은 Vision AI와 다른 데이터 유형(예: 언어, 음성)을 결합하여 복합적인 의미를 이해하는 첨단 기술입니다. 이 기술은 이미지나 비디오와 같은 시각적 정보를 텍스트, 음성 등 다른 형태의 데이터와 통합하여 더 풍부하고 정확한 해석을 가능하게 합니다. 예를 들어, 이미지에 대한 자연어 설명 생성, 비디오 내용과 자막의 동기화, 음성 명령과 시각 정보를 결합한 AI 비서 등이 멀티모달 비전의 응용 사례입니다. CLIP(Contrastive Language–Image Pretraining)은 이 분야의 대표적인 기술로, 대규모 이미지-텍스트 쌍을 학습하여 다양한 시각 작업에 활용할 수 있습니다. 최근에는 GPT-4와 같은 대규모 언어 모델과 Vision AI를 결합한 멀티모달 AI 시스템이 등장하여 이미지 이해와 생성 능력을 크게 향상시켰습니다. 이러한 발전은 인간의 복합적인 인지 능력에 더욱 가까워지는 AI 시스템을 구현하여, 교육, 헬스케어, 로봇공학, 가상/증강 현실 등 다양한 분야에서 혁신적인 응용을 가능케 하고 있습니다.

마무리

Vision AI의 10가지 핵심 기술을 통해 우리는 인공지능이 어떻게 세상을 '보고', '이해하고', '창조하는지' 살펴보았습니다. 이 기술들은 단순한 알고리즘의 집합이 아닌, 우리 사회를 근본적으로 변화시키는 혁신의 원동력입니다. 의료 진단의 정확성 향상, 자율주행의 안전성 제고, 산업 현장의 효율성 증대 등 Vision AI는 이미 우리 삶 곳곳에 스며들어 있습니다. 그러나 이는 시작에 불과합니다. 앞으로 Vision AI는 더욱 정교해지고, 다른 기술들과 융합하며 우리가 상상하지 못한 새로운 가능성을 열어갈 것입니다.