AI 개발 실전 노하우, 여기서 다 풀었다! 라이브 Q&A 총정리

지난 10월 29일 진행된 Superb AI의 첫 온라인 이벤트, 'AI 딥-다이브'에서는 AI 기술의 최전선에 대한 뜨거운 관심이 모였습니다.

Superb AI의 비전 파운데이션 모델 제로(ZERO) 개발을 위한 데이터 구축 비하인드와 CVPR 2025 AI 챌린지 준우승이라는 성과를 만든 최상범 ML 엔지니어의 발표 이후, 참가자분들은 모델 개발 과정과 기술 방향성에 대한 깊이 있는 질문들로 이벤트를 풍성하게 만들어주셨는데요.

이번 글에서는 모델 제로(ZERO)의 경쟁력, 데이터 활용 전략, 그리고 MLOps 기업의 VFM 개발 인사이트까지! 참가자들이 가장 궁금해했던 질문과 답변을 총정리했습니다. 지금 바로 솔직하고, 핵심적인 Q&A를 확인해보시죠.

Part 1. AI 산업 동향 및 비전 분야의 미래

Q. 현재 업계 동향 및 앞으로의 발전 방향이 궁금합니다.

A. 기존의 고전적인 컴퓨터 비전 모델(Object Detection, Classification 등)부터 시작해 지금은 MLLM(멀티모달 라지 랭귀지 모델) 혹은 VLM(비전 랭귀지 모델)로 변하고 있는 추세입니다. 앞으로의 방향도 이러한 멀티모달 모델이 주를 이룰 것 같습니다.

다른 관점으로는, 이벤트 며칠 전 얀 르쿤이 한국에 와서 표현한 바에 따르면 '라지 랭귀지 모델의 시대는 가고 월드 모델의 시대가 올 것'이라고 말했습니다. 월드 모델에 대한 정의는 요즘 새롭게 제안하는 모델이기에 아직 조금 모호하지만, 이러한 키워드들에 대해 알고 계시면 좋을 것 같습니다.

Q. 컴퓨터 비전의 최근 트렌드와 앞으로의 과제들, 그리고 모르면 안 되는 테크닉이 궁금합니다.

A. 아이러니하게도 컴퓨터 비전을 공부하더라도 LLM(대규모 언어 모델)에 대한 이해는 필수적입니다. Transformer에 대한 이해, Pre-training/Post-training이 왜 나뉘는지, LLM이 왜 비전보다 더 발전하는지 등 데이터적인 접근을 이해한 이후 MLLM, VLM과 같은 분야에 대한 공부를 시작해 보는 것이 좋습니다.

3D나 자율주행 분야는 이러한 트렌드에 다소 덜 민감하긴 하지만, 앞으로도 LLM 발전에 따른 MLLM의 발전 속도 또한 이어질 것이기에 매우 중요한 요소일 것입니다. 추가로 기존에 배웠던 HOG/SHIFT와 같은 고전적인 알고리즘 사용은 적어지고 있는 추세로 보입니다. 시대가 지날수록 배워야 할 정보량이 많으니, 어떤 분야가 미래에 유망할지 고민할 때는 데이터를 어떻게 구성하는지 관점으로 살펴보면 좋을 것 같습니다.

Q. 최근 AI 업계 전반이 LLM과 멀티모달로 빠르게 이동하고 있는데, Superb AI에서는 비전 분야의 위치를 어떻게 보고 계신가요?

A. MLLM 및 LLM은 ‘두뇌’로 급성장 중이고, Superb AI는 그 두뇌가 믿고 쓸 수 있는 ‘눈(비전)’을 더 강하게 만드는 쪽에 집중합니다. ZERO 모델을 기반으로 멀티모달·에이전트와 유기적으로 결합하여, “현장에서 통하는 AI”를 끝까지 책임지는 것이 Superb AI의 방향입니다.

Part 2. 모델 :ZERO 개발 과정과 데이터 전략

Q. 특정 주제나 분야에 한정되지 않은 범용(General) 모델을 개발하는 과정이 궁금합니다. 다양한 사례를 경험하며 공통적인 요소를 추출하는 방식인지, 그리고 이러한 과정 자체가 각 회사의 핵심 경쟁력이 되는 것인지 기술적인 관점에서의 의견이 궁금합니다. 또한, 타사와 비교했을 때의 구체적인 경쟁력에는 어떤 차별점이 있는지도 알고 싶습니다.

A. 우선 저희 회사는 고객에 따라서 맞춤 모델을 만들어주는 자동화 플랫폼이 존재하고, 여기에 등록된 모델이 아마 1만 개 이상이 되는 것으로 알고 있습니다. 이는 모델들이 굉장히 파편화되어 있고 데이터 또한 파편화되어 있다는 뜻인데, 이것을 중앙 집중화(Centralize)하기 위해서 파운데이션 모델을 만들었습니다. 말씀해 주신 대로 자동화의 영역도 있고, 수동적으로 다양한 사례에 대한 경험들을 요약하여 공통 요소로 뽑는 경우도 확실히 존재합니다.

기술적 관점에서 구체적인 경쟁력은 아키텍처라고 생각하지 않습니다. 현실적으로 저희도 새로운 기술들이 나오면 계속해서 저희 모델에 적용해보고 변화를 줄 것이기 때문입니다. 결국 경쟁력은 성능이라고 말할 수 있을 것 같습니다. 현재 이러한 서비스를 하고 있는 회사는 중국에 1개 정도라고 파악하고 있는데요. 저희가 Industrial 도메인에 대한 성능은 100% 이상 높은 상태입니다.

Q. 파운데이션 모델 학습을 위한 최소한의 데이터 양은 어떻게 되나요? 또한 라벨링은 어떤 형식으로 진행되는지?

A. 파운데이션 모델 학습에 정의되어 있는 최소 데이터의 양은 없습니다. 그러나 여러 논문들을 비교/대조해 본 결과 약 1,000만 장 정도는 되어야 Production에 쓰일 수 있을 만큼 안정적이라고 보이는데요. 현재 저희는 1년 안에 1,000만 장 정도까지 도달하고자 합니다.

라벨링 형식 또한 정해진 것은 없습니다. 다만 구글이나 메타처럼 대기업이 아닌 경우 기존 Legacy 데이터셋들의 레버리지를 적극 활용하는 것이 중요합니다. 데이터 규모로 보면 Image Caption에 대한 정보가 시중에 가장 많이 나와있고, Laion2B, Kakao의 Coyo-700M과 같은 데이터셋들이 억 단위의 데이터셋들로 구성되어 있으니 여기서부터 출발하는 것이 좋아 보이고, 그 이후에는 원하는 형식을 만들어 가는 것이 중요합니다.

Q. 데이터 구축 과정에서 어떤 부분에 가장 중점을 두는지 궁금합니다. 또한, 양질의 데이터를 현실적으로 어떻게 확보하는지, 그 과정에서 어떤 어려움이 있는지 알고 싶습니다. 더불어 방법을 적용하거나 개발을 진행하는 과정에서 발생하는 주요 어려움에는 어떤 것들이 있는지도 궁금합니다.

A. 데이터 구축 과정에서 첫 번째 주안점은, 같은 축구 사진이라도 어떤 고객은 축구공만 라벨링하길 원하는 반면, 다른 고객은 심판만 라벨링하길 원한다는 점입니다. 즉, 고객별로 목표하는 객체나 관심사가 다르기 때문에 일괄적인 라벨링 기준이 아닌 맞춤형 기준이 필요합니다. 이로 인해 데이터셋의 범위와 세분화 방법이 크게 달라지고, 프로젝트마다 달라진 요구사항에 맞춰 정밀하게 데이터를 구축해야 합니다.

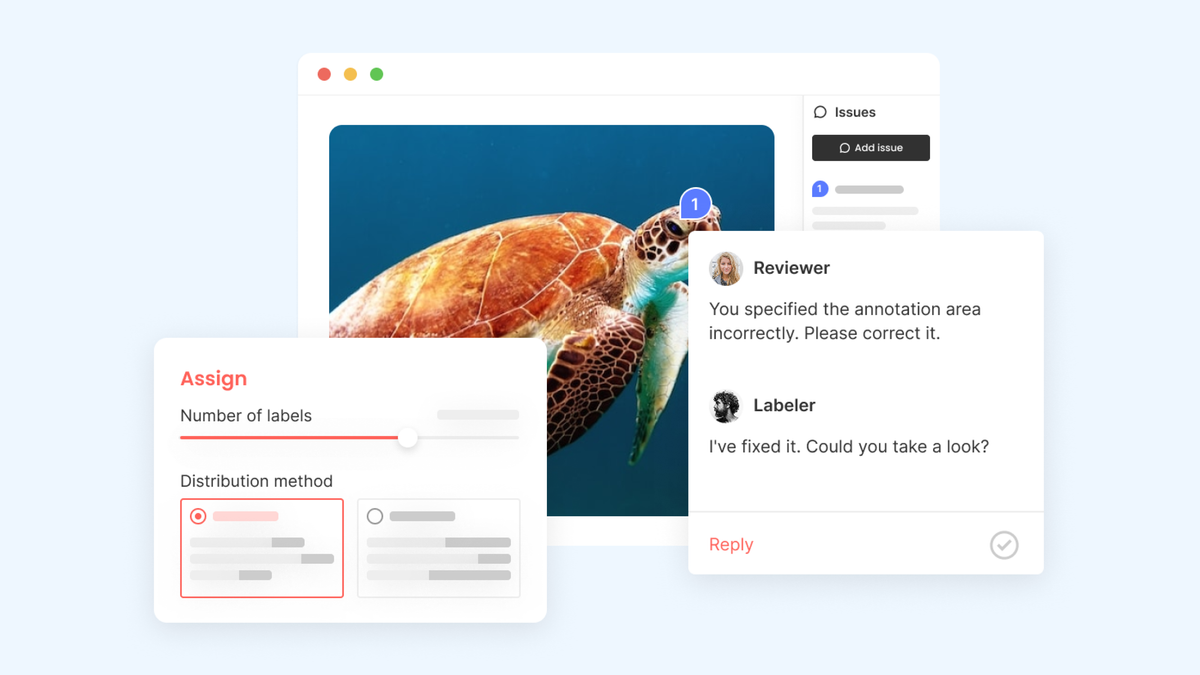

두 번째로 중요한 점은 라벨링된 데이터들의 평가를 자동화하기가 매우 어렵다는 것입니다. 자동 라벨링 도구가 있어도, 그 정확도와 신뢰성을 확보하기 위해서는 수동 검수가 필수적입니다. 자동화 모델은 초기 훈련 데이터에 크게 의존하기 때문에, 샘플 데이터 품질에 따라 오류가 발생할 수 있고, 잘못된 라벨이 반복적으로 생성될 위험이 있습니다. 또한 모델이 잘 처리하지 못하는 엣지 케이스의 경우, 사람의 개입 없이는 올바른 라벨을 보장할 수 없습니다. 그래서 데이터 라벨링 오류를 최소화하고 AI가 제대로 학습할 수 있도록 하는 품질 관리와 평가 작업은 여전히 사람의 판단과 감독이 중요한 역할을 차지합니다.

Q. 데이터 필터링 시 롱테일 분포를 활용한다고 하셨는데, 어떤 식으로 필터링에 활용하시는 걸까요?

A. 가장 간단하게 데이터의 비율을 맞추는 것입니다. 롱테일 분포를 예로 들면, 모든 데이터셋 중에 사람에 해당되는 카테고리가 가장 많을 텐데요. 제조 도메인에서 톱니바퀴가 깨진 사진이 가장 적은 데이터 분포를 가진다고하면, 결국 이러한 데이터의 비율을 맞추는 것이 가장 간편한 활용 방법입니다.

Q. Unlabeled data를 labeling할 때 Auto-labeling Auto QA pipeline의 결과와 Fine-grained auto-labeling pipeline 결과가 어떻게 결합되어 label로 저장되는지 궁금합니다.

A. 첫 번째 파이프라인인 Auto-labeling + Auto QA pipeline은 보수적인 기준으로 동작합니다. 즉, 모델이 매우 높은 확신을 가지고 탐지한 객체만을 라벨로 채택해 정확도(precision)를 높이는 데 초점을 둡니다. 반면 두 번째 파이프라인인 Fine-grained auto-labeling pipeline은 보다 개방적인 기준을 적용합니다. 이는 데이터의 다양성과 정보량을 최대화하기 위해, 다소 확신도가 낮더라도 의미 있는 후보 객체들을 추가로 포함시키는 방식입니다.

최종적으로는 두 결과를 단순히 병합하는 것이 아니라, 첫 번째 파이프라인에서 탐지되지 않은 영역을 기준으로 두 번째 파이프라인의 결과를 보완적으로 결합합니다.

결국, 두 파이프라인은 각각 정확도 중심의 탐지와 포괄적 정보 확보라는 역할을 나누고 있으며, 이 두 결과가 보완적으로 결합되어 최종 라벨 데이터로 저장되는 구조입니다.

Q. Auto-labeling 과정에서 Foundation Model을 활용하는 것으로 이해했습니다. 이러한 모델들도 의학 분야처럼 생소한 도메인에서는 성능이 낮을 수 있을 것 같은데요. 이런 경우 모델의 결과를 별도로 보정(correction) 하셨는지, 보정하셨다면 구체적으로 어떤 방식으로 진행하셨는지 궁금합니다.

A. 도메인이 굉장히 특수해지거나(Specific) 세분화될 수록(Fine-grained) 저희가 만들어 놓은 오토 라벨링 파이프라인임에도 불구하고 유의미한 정보가 안 나오는 경우가 많이 있습니다. 그렇기 때문에 사실 저희는 이것뿐만 아니라, 초기에 그러한 도메인들을 미리 선정해서 GT(Ground Truth)가 있는 데이터셋들로 미리 학습을 시켰었습니다. 이렇게 학습된 1차 버전의 ZERO 모델들을 오토 라벨링 파이프라인에 녹이는 과정이 있다 보니, 원래는 안 되었어야 하는 것들도 1차 버전에는 GT가 있는 데이터셋들로 학습을 했기 때문에 비교적 상대적으로 더 많이 잘 나오게 할 수 있었습니다.

Q. Mislabelling (오라벨) 자체도 머신러닝으로 검토가 가능한가요?

A. 네, 내부적으로 이러한 개념을 가지고 있습니다. Mislabelling은 두 가지 개념이 있습니다. 하나는 예를 들어서 강아지를 고양이라고 표현한 경우이고, 다른 하나는 원래 강아지를 검출해냈어야 하는데 검출을 못 한 경우입니다. 전자의 경우(잘못된 카테고리)는 머신러닝으로 비교적 쉽게 검출해 낼 수 있고요. 반면에 후자(미검출)를 검출하는 과정은 조금 더 어려운 머신러닝이긴 하지만, 어느 정도는 가능합니다. 완벽하게 100% 된다고 표현하기는 힘들고, 가능하다 정도라고 표현하는 것이 맞을 것 같습니다.

Q. VLM 모델을 활용해 데이터 Auto-labeling 프로세스를 수행한 것으로 이해했습니다. 이 과정에서 사람의 검수(Human verification) 없이 모델만으로 라벨링이 이루어지는지 궁금합니다. 만약 완전히 모델에 의존하는 방식이라면, Auto-labeling 과정에서 발생할 수 있는 오탐(False Positive)이나 잘못된 라벨(O-label)로 인해, 결과 데이터에 노이즈가 포함되거나 모델 학습에 부정적인 영향을 미치는 사례가 있었는지도 궁금합니다.

A. 네, 실제로 오탐 케이스가 발생하며, 저희도 그것을 계속 고치고 있습니다. 말씀하신 대로 사람이 검수를 하지 않으면 AI 모델로만 검출된 객체들의 오탐이 확실히 끼어 있습니다. 그렇기 때문에 저희는 이 오탐의 영역을 최대한으로 줄이기 위해 특정 수치들을 굉장히 보수적으로 산정해 두었습니다. 이러한 오탐을 사람이 직접 보지 않고도 대시보드를 보는 것만으로 검출할 수 있게끔 평가 지표들을 따로 마련하려고 하고 있습니다. 이처럼 사람의 투입 시간을 최소화하려고 노력하고 있으며, 실제로도 이런 오탐들을 발견하고 수정하고 있습니다.

Q. 아무리 파운데이션 모델이라도 특정 도메인에 적용하기 위해서는 어느 정도 fine-tuning이 필요하지 않은지요? 여러 사례를 보기는 했는데 어느 정도의 데이터 량이 최소치를 보고 있는지요?

A. 말씀해주신 것도 맞습니다. 특정 도메인에 적용하기 위해 fine-tuning이 필요할 수 있습니다(필요할 수도 있고 아닐 수도 있습니다). 이러한 데이터양의 최소치에 대해 저희는 최대한 10장으로도 가능하게끔 하는 리서치를 하고 있고, 최대한 적은 양의 데이터셋으로 파인튜닝이 가능하도록 개념을 제안하려고 합니다.

Q. Single image에 대해 적용되는 솔루션으로 이해했는데, 동영상 입력에 대해서도 적용될 계획이 있으신가요?

A. Single image에 대해 적용되는 솔루션이 맞습니다. 동영상 입력에 대해서도 확장이 될 수 있습니다. 기본적으로 단순히 동영상을 이미지 시퀀스로 변환한 다음 추론(Inference)을 하는 개념도 동영상 입력이긴 합니다만, 조금 더 확장적으로 동영상의 시퀀스들 간의 이해를 실제 모델에 입력하는 개념 또한 적용하려 합니다. SAM3 논문이 출시되면 그 개념을 바탕으로 다시 한번 내부 IP 파인튜닝할 계획도 있습니다.

Q. 더 높은 성능 요구하는 상황이라면, zero-shot이 가능한 VFM에 학습 데이터를 더 많이 추가할수록 더 큰 성능 향상을 보이나요? 데이터를 추가할수록 얼마나 큰 성능 향상이 있을 수 있는지 궁금합니다.

A. 대학원생 혹은 연구자분들은 아시겠지만, ICCV/CVPR에 SOTA라고 논문을 내면 기존에 비해서 1~2 AP만 증가하더라도 그 영향력을 인정받습니다. 이것도 좋은 결과이지만, 질문 주신 학습 데이터를 추가할수록 더 큰 성능 향상은 여기서 최소 5 AP 이상의 성능 향상을 보입니다. 이것이 학계와 다른 점인데요. 학계의 논문들은 Active learning이나 Dataset 관련 주제가 아닌 이상 데이터를 정해두고 실험해야 하는데, 업계에서는 이러한 제약이 있지 않고, 성능을 가장 쉽게 그리고 확실하게 올리는 방법은 데이터 정제입니다. "Garbage in, garbage out"은 언제나 제가 생각하는 모토 중 하나입니다.

Part 3. 모델 배포, 비용, 비즈니스 모델

Q. AI/ML 모델을 고객사에 적용 및 사용하기 위해 개발을 한다면 초기 커스터마이징 요소가 발생할는지요. 발생한다면 그 소요 공수는 얼마큼 될 것인지요?

A. 저희는 말씀하신 기능을 Superb Model이라는 제품으로 제공하고 있습니다. 만약 슈퍼브 모델을 사용하신다는 가정하에는 데이터만 있으시면 특별히 다른 공수 없이 바로 적용을 해보실 수 있을 것 같습니다. 그게 아니라면 더 많은 기간이 걸릴 것이며, 그것은 원하시는 모델의 성능과 현장 상황에 따라 다를 수 있을 것 같습니다.

Q. Zero 모델 및 이를 활용한 Superb AI의 비즈니스 모델이 궁금합니다.

A. Superb AI의 ZERO 모델은 범용적인 비전 기반 모델로, 이를 Vertical Solution(산업 특화 솔루션) 형태로 확장하고 있습니다. 특히 영상 관제(Video Analytics) 분야에서 ZERO 모델이 큰 강점을 보입니다. 이미 대규모 비전 데이터를 학습한 모델을 기반으로 하기 때문에, 고객사는 추가 데이터 수집이나 장시간의 학습 없이도 즉시 현장에 적용 가능한 수준의 성능을 확보할 수 있습니다.

또한 ZERO 모델은 단순한 시각 정보 처리뿐 아니라 텍스트, 프롬프트 등 다양한 입력을 이해하고 처리할 수 있는 멀티모달 능력을 갖추고 있습니다. 이러한 특성 덕분에 Superb AI는 고객이 빠르게 AI를 도입하고 실질적인 성과를 낼 수 있는 End-user 솔루션을 제공하고 있으며, 향후에도 산업별 특화 모델로의 확장을 지속할 계획입니다.

용어 정리 💡

| 용어 | 풀이 |

|---|---|

| LLM (대규모 언어 모델) | 방대한 텍스트 데이터를 학습하여 인간처럼 언어를 이해하고 생성하는 AI 모델. |

| HOG/SHIFT | HOG(Histogram of Oriented Gradients) 및 SIFT(Scale-Invariant Feature Transform). 딥러닝 시대 이전에 컴퓨터 비전 분야에서 객체 인식 및 특징 추출을 위해 널리 사용되던 고전적인 알고리즘. |

| 멀티모달 | 텍스트, 이미지, 음성 등 여러 종류의 데이터를 동시에 이해하고 처리하는 기술. |

| MLLM (멀티모달 라지 랭귀지 모델) | 여러 종류의 입력(예: 텍스트와 이미지)을 동시에 이해하고 처리할 수 있도록 확장된 대규모 언어 모델. |

| VLM (비전 랭귀지 모델) | 이미지나 영상을 텍스트(언어)와 함께 이해하고 처리할 수 있는 시각 중심의 멀티모달 모델. |

| 월드 모델 | 세상의 인과관계와 상호작용 방식을 학습하여 미래 상황을 예측하거나 시뮬레이션할 수 있는 AI 모델 (최근 연구 개념). |

| Fine-tuning (파인튜닝) | 이미 학습된 모델을 특정 목적에 맞게 소량의 데이터로 추가 학습시켜 성능을 최적화하는 과정. |

| Inference (추론) | 학습된 AI 모델에 새로운 데이터를 입력하여 결과를 예측하거나 출력하는 과정. |

| Model Artifact | 학습된 모델 파일, 설정 파일 등 모델을 배포하고 실행하는 데 필요한 모든 구성 요소. |

| MLOps | Machine Learning Operations. 머신러닝 모델의 개발, 배포, 모니터링 및 관리를 자동화하고 체계화하는 시스템. |

| On-premise (온프렘) | AI 시스템을 클라우드가 아닌 기업 내부 전산실 등에 직접 설치하고 운영하는 방식. |

| Edge Case (엣지 케이스) | 일반적이지 않고 극단적이거나 예외적인 경우. AI 모델 개발 시 오류가 발생하기 쉬운 부분. |

| AP | Average Precision. 객체 탐지 등 컴퓨터 비전 모델의 성능을 평가하는 대표적인 지표. |

| GPU VRAM | 그래픽 처리 장치(GPU)에 탑재된 전용 메모리 용량. AI 모델 추론 시 사용됨. |

| Transformer (트랜스포머) | 2017년 구글이 제안한 신경망 모델 아키텍처. 입력 데이터를 순차적으로 처리하지 않고 한 번에 처리(Attention 메커니즘)하여 LLM 등 최신 AI 모델의 핵심 기반이 됨. |

| S3 | AWS에서 제공하는 대규모 클라우드 저장 공간 서비스. |