초거대AI의 Phase.2: 비윤리성과 편향성 - AI 윤리 준칙이 필요한 이유

초거대AI를 대하는 우리의 자세

안녕하세요, IT린이 제나팡입니다 :) 오늘은 초거대AI의 Phase.2 : 비윤리성과 편향성에 대해 알아보겠습니다. 대화형AI의 기술 진화 속도에 감탄하는 것에서 더 나아가, 우리가 앞으로 초거대AI를 활용하면서 혹은 개발하면서 가져야 하는 자세에 대해 다같이 고민해보고자 이번 글을 준비했습니다.

Phase.1 : 초거대AI 개발에 앞다투는 글로벌&국내 빅테크

먼저, 초거대AI의 Phase.1에 대해 알아볼게요. 22년 11월부터 ChatGPT 등장 이후 전세계는 초거대AI에 대해 열광하고 있습니다. 초거대AI는 반짝 떴다가 사라지는 트렌드가 아니라, 우리의 일상과 비즈니스에 항상 같이 하는 존재가 되었습니다. 특히 빅테크 기업들은 적극적인 대응 행보를 보이고 있습니다.

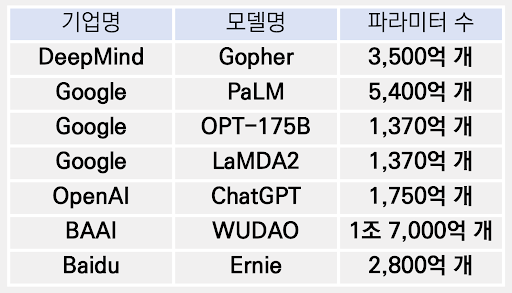

이외에도 마이크로소프트는 12조원의 자금을 오픈AI에 투자하며, 전략적 파트너십을 기반으로 MS 협업툴, 검색엔진에도 ChatGPT를 접목해 나가며 ‘AI시대의 시작'을 선언했습니다. 대부분이 영어 중심의 서비스를 제공하지만, 중국판 ChatGPT라고 불리는 Baidu의 Ernie는 지난 3월에 공개되어, (아직은 미흡하지만) 중국어 기반으로 중국 내에서 유용하다고 평가되고 있습니다.

한편, 국내 기업은 빅테크와 통신사를 중심으로 초거대AI 개발이 이루어지고 있습니다. 아무래도 글로벌 서비스는 한국어 서비스를 한국이 만족할 만큼은 지원하지 못하기 때문에, 이를 블루오션으로 판단하고 우리말 서비스에 집중하고 있는 것이죠.

다만, LG의 EXAONE을 제외하고는 국내 초거대 AI의 파라미터 수는 앞서 언급된 글로벌 초거대 AI의 파라미터 수에 비해 현저히 적은 개수임을 알 수 있습니다. 따라서 정확성과 범용성이 떨어진다는 평가를 받기도 하죠.

해외에서 떠오르는 비윤리성&편향성 이슈

ChatGPT가 공개된 이후 6개월이 지난 이 시점에서, 모델 개발 현황 이외에 우리는 어떤 것에 관심을 가져야 할까요. 초거대 AI를 활용하는 사례가 많아지면서, 비윤리성과 편향성 이슈 또한 떠오르고 있습니다. 이는 결국 사전 학습 데이터의 신뢰성에서 기인하는 문제인데요.

해외에서는 문제 해결을 위해 빅테크 IT 기업의 학습데이터를 검증하려는 시도를 하고 있습니다. 예를 들어 구글은 이미지 처리 AI에 활용되는 MST(Monk Skin Tone, 몽크 스킨 톤) 피부색 구현 체계를 구현했습니다. 인종이 아닌 피부의 채도에 따라 10단계로 이미지를 처리하여, 인종적 편향성을 낮추려는 노력인 것이죠.

MIT Technology Review에서는 ‘편견과 고정관념을 심화시키는' AI 이미지 생성형 시스템에 대한 연구 결과를 소개하기도 했습니다. 독일 라이프치히 대학교의 연구원들은 DALL-E 2와 Stable Diffusion에 포함된 평향성을 직접 확인했는데요.

각 모델에서 생성된 이미지들을 분석한 결과 AI 이미지 모델이 기본적으로 백인 남성으로 보이는 이미지를 생성할 가능성이 높았습니다. 특히 DALL-E 2는 편향성이 매우 큰 모델로, CEO와 같은 지시어에 백인 남성 이미지가 생성되는 경우가 97% 이상이었습니다. 즉, AI 모델의 훈련 과정에서 인종과 성별에 대한 고정관념이 반영될 수 밖에 없는 것이죠.

국내에서 떠오르는 비윤리성&편향성 이슈

국내에서도 AI 윤리 준칙이 발표되고 있습니다. 예를 들어 KAIST에서는 공정성 연구센터에서 모델의 검증하기 위한 프레임워크 MSIT AI FAIR 2022를 개발하며, 연구소 차원에서 다양한 방법을 고안하고 있구요.

네이버, 카카오, LG를 비롯한 국내 테크 기업은 AI 윤리 재정비에 나서고 있습니다. 전담 조직을 신설하며 선제적으로 AI 윤리 준칙을 만들고 이를 각사 서비스와 제품에 내재화를 하기 위해 노력 중이죠. 특히 네이버는 AI 윤리 준칙을 정립하기 위해 관련 전문가 뿐만 아니라, 법학, 인문학, 철학 등 교수들과 함께했다고 하죠.

또한, AI 윤리에 대한 첫 번째 국가표준(KS)가 제정되었습니다. 기업이 AI 제품이나 서비스를 개발할 때 참고가능한 체크리스트가 만들어진 것이죠. 업통상자원부 국가기술표준원은 ‘AI 윤리 점검 서식'에 대한 KS를 제정하고 AI 제품 및 서비스 관련 기업을 대상으로 AI 윤리 KS 제정 설명회를 개최하기도 했구요.

결국은 기업의 ‘노력'이 중요한 문제

ChatGPT의 등장으로 인간은 처음으로 인공지능이 사람 수준의 지적 능력을 능가할 수 있다는 가능성과 위기의식을 체감하게 되었습니다. 특히 거짓정보 생성과 고정관념 강화 등 인공지능의 위험성이 윤리의 문제와도 직결되고요. 앞으로 더 많은 초거대AI 서비스가 개발되고, 이러한 서비스가 점점 더 많은 산업과 일상의 영역에 영향을 주겠지요? 그만큼 AI의 윤리에 대한 문제에 모두가 집중해야 하는 것 같습니다.

다만, 정부 주도의 AI 윤리 논의가 진행되더라도 결국 기업의 ‘자율적' 노력이 중요한 것이니 기업 자체적으로 윤리 의식을 높이는 노력도 꾸준히 진행되기를 바랍니다.

| ||

잇린이(IT+린이) 제나팡입니다. 문돌이의 IT 이슈 따라잡기, 함께 할까요? |

* 슈퍼브 블로그의 외부 기고 콘텐츠는 외부 전문가가 작성한 글로 운영 가이드라인에 따라 작성됩니다. 슈퍼브 블로그에서는 독자분들이 AI에 대한 소식을 더 쉽고 간편하게 이해하실 수 있도록 유용한 팁과 정보를 제공하고 있습니다.